IoT, Cloud, Security & Co.

03.11.2017, 11:32 Uhr

Das sind die wichtigsten IT-Trends 2018

Online PC fasst die wichtigsten Trends für 2018 zusammen, spricht mit Branchenkennern und zeigt, was für IT-Verantwortliche wirklich wichtig wird.

Es gibt wohl kaum eine Branche, die sich so schnell wandelt wie die Informationstechnologie. Wenn man sich die atemberaubende Entwicklung der letzten 20 Jahren ansieht, dann fällt auf, dass Veränderungen in der IT zur Normalität gehören – aber nicht immer passieren sie so schnell wie im Moment.

Die Themen Digitalisierung und Industrie 4.0 bringen für Unternehmen komplett neue Herausforderungen mit sich. Immer stärker automatisierte Geschäftsprozesse erhöhen den Druck, neue Geschäftsmodelle für die Digitalisierung zu entwickeln.

Auch wenn Stillstand also quasi Rückschritt bedeutet, stellt sich für viele IT-Entscheider dennoch die Frage, ob man wirklich jedem Hype folgen und jede neue Technologie mitnehmen muss. Was kommt im Jahr 2018 auf die IT-Branche zu? Welche neuen Technologien werden das Rennen machen? Und um welche kommt man als IT-Entscheider nicht herum?

Online PC fasst die wichtigsten Trends zusammen, spricht mit Branchenkennern und zeigt, was für IT-Verantwortliche wirklich wichtig wird.

Übrigens: Für die IT-Abteilungen hat sich trotz ständig neuer Technologien und neuer Herausforderungen durch die Digitalisierung eigentlich gar nicht so viel verändert: Die Hauptaufgabe ist nach wie vor, zuverlässige IT-Systeme zur Verfügung zu stellen. Was sich aber laufend verändert, ist die Art und Weise, wie diese zur Verfügung gestellt werden.

Neuer Level für alte Trends

Im kommenden Jahr wird es vor allem darum gehen, die vorhandenen Techniken und Themen in die Praxis umzusetzen. „Die dominierenden IT-Themen aus dem Jahr 2017 werden den Markt auch weiterhin am meisten umtreiben. Ob es eine erhöhte Nachfrage für bestimmte Trends und entsprechende Lösungen geben wird, hängt massgeblich davon ab, ob Umsetzungen beim Kunden zu wiederholbarem Geschäft führen oder ob es beim Testen der Technologien bleibt“, so die Einschätzung von Maik Hähnel, Chief Technology Officer bei Vinci Energies Deutschland ICT und Axians.

“„Nachdem Unternehmen bisher vielfach nur punktuelle Aktivitäten in den verschiedenen Digitalisierungstechnologien umgesetzt haben, werden sie jetzt zunehmend breit aufgestellte Digitalisierungsstrategien für große Bereiche oder für das gesamte Unternehmen entwickeln.“„

Bernhard Kube

Vice President Technology Consulting bei Lufthansa Industry Solutions

Ähnlich sieht es Johannes Wagmüller, Director Systems Engineering CEMA beim Storage-Anbieter NetApp: „Mit durchschlagender Breitenrelevanz für den Massenmarkt binnen Jahresfrist zeichnet sich noch nichts erkennbar ab, was nicht schon in Ansätzen bekannt ist. Ich würde sagen, die bestehenden Trends erreichen das nächste Level.“

Kurzfristig wird es nach Meinung von Christian Hopfner, Head of Business Development beim IT-Haus All for One Steeb, vor allem um die weitere Mobilisierung von Prozessen, das Vereinfachen von Anwendungen, die Nutzung von Informationssystemen wie Business Analytics sowie um modernes Arbeiten etwa mit Collaboration gehen. „Unternehmen, die diese Themen bereits angegangen sind beziehungsweise in deren Branchen es nötig ist, um wettbewerbsfähig zu bleiben, werden das Thema Digitalisierung weiter vorantreiben.“

Im nächsten Jahr heisst es also für viele Firmen, bei der Digitalisierung am Ball zu bleiben: „Nachdem Unternehmen bisher vielfach nur punktuelle Aktivitäten in den verschiedenen Digitalisierungstechnologien umgesetzt haben, werden sie jetzt zunehmend breit aufgestellte Digitalisierungsstrategien für grosse Bereiche oder für das gesamte Unternehmen entwickeln.“ So fasst Bernhard Kube, Vice President Technology Consulting bei Lufthansa Industry Solutions, die Trends für das kommende Jahr zusammen.

Hybrid Clouds und Data Gravity

Dass an der Cloud kein Weg mehr vorbeiführt und sie ein essenzieller Treiber der digitalen Transformation ist, dürfte mittlerweile jedem IT-Verantwortlichen klar sein. Das Outsourcing der IT-Landschaft in die Cloud ist in vielen Unternehmen längst ein Thema. „2017 war das Jahr, in dem die Cloud-Technologie auf breiter Front Einzug in die Strategien der klassischen IT-Abteilungen gehalten hat. Dieser Trend wird sich 2018 fortsetzen“, so Bernhard Kube. Er geht davon aus, dass zunehmend Plattformdienste der Cloud-Anbieter zum Einsatz kommen. Ausserdem sollen vermehrt Anwendungen für die Cloud als „Cloud-native“-Apps erstellt, containerisiert und orchestriert werden.

Auch Felix Blank, Senior Product Manager beim Cloud-Sicherheitsanbieter Secucloud, sieht die Cloud in Unternehmen mittlerweile als einen etablierten Standard: „Die Cloud breitet sich kontinuierlich aus und vor allem die ständig steigenden Bandbreiten tragen zur immer stärkeren Etablierung der Technologie bei.“

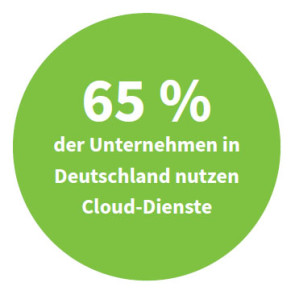

Das spiegelt sich auch im „Cloud-Monitor 2017“ des Beratungshauses KPMG wider: 65 Prozent der Unternehmen in Deutschland nutzen Cloud-Dienste, weitere 18 Prozent planen oder diskutieren deren Einsatz. „Die Cloud als Grundlage für digitale Transformation und digitale Geschäftsmodelle ist ein zentrales Thema in Kundengesprächen.“ So erlebt es Klaus Weinmann, CEO beim IT-Dienstleister Cancom, in seinem Alltagsgeschäft.

“„Immer bessere Technologien aus den Bereichen Machine Learning und Business Intelligence analysieren gigantische Datenmengen und werten diese aus.“ „

Dabei setzen allerdings bislang nur wenige Unternehmen auf Public-Cloud-Dienste: Zwar nutzt die Hälfte der grossen Unternehmen mit mehr als 2000 Mitarbeitern bereits Public Clouds, bei kleinen und mittelständischen Firmen sind es hingegen erst 29 Prozent.

Das liegt mit Sicherheit auch daran, dass über zwei Drittel aller Unternehmen die Sorge haben, dass die Cloud-Nutzung die Einhaltung der Compliance-Anforderungen gefährdet. Trotz berechtigter Zweifel an der Datensicherheit: Es sind vor allem Public-Cloud-Dienste, bei denen sich alle Kunden eines Dienstes dessen Server teilen, die Kosten einsparen und etliche grosse Dienste erst möglich gemacht haben.

Eines der bekanntesten Beispiele für den Erfolg mit der Public Cloud ist der Streaming-Dienst Netflix. Seit letztem Jahr laufen alle Daten und Dienste in der Cloud. Netflix setzt dabei auf den Public-Cloud-Dienst Amazon Web Services (AWS). Ob verteilte Datenbanken, die Verarbeitung und Analyse grosser Datenmengen oder die den Nutzern angezeigten Empfehlungen – für alle Funktionen nutzt Netflix die Cloud. Die erforderliche Skalierbarkeit wäre ohne den Einsatz eines Cloud-Dienstes nach Angaben des Streaming-Anbieters kaum möglich gewesen.

Doch der Trend geht nicht nur zur Nutzung einer einzigen Cloud – vielmehr gilt die Hybrid Cloud als IT-Architektur der Zukunft. „Um agil zu sein, werden Unternehmen verstärkt auf Hybrid Cloud setzen. Das heisst, Services aus multiplen Clouds zu beziehen – inklusive der eigenen –, wird zum Standard“, so Johannes Wagmüller von NetApp. Vor allem in Bezug auf die im Mai 2018 in Kraft tretende Europäische Datenschutz-Grundverordnung wird nach Ansicht von Wagmüller das Datenmanagement und dessen Auditierbarkeit noch stärker in den Fokus rücken. „Unternehmen müssen aufzeigen können, wo sie Daten speichern und wie sie den Anforderungen gerecht werden.“

“ „Um agil zu sein, werden Unternehmen verstärkt auf Hybrid Cloud setzen. Das heißt, Services aus multiplen Clouds zu beziehen – inklusive der eigenen –, wird zum Standard.“„

Ähnlich äussert sich Bernhard Kube von Lufthansa Industry Solutions: „Die Umsetzung der neuen Anforderungen der EU-Datenschutz-Grundverordnung beschäftigt die Unternehmen noch stark. Sie müssen ihre Datenverarbeitung auf den Prüfstand stellen und sich gleichzeitig um neue Lösungen kümmern, um das Risiko von Verstössen frühzeitig zu minimieren und die Funktionsfähigkeit ihrer auf Daten basierenden Geschäftsprozesse sicherzustellen.“

In vielen Unternehmen lassen sich die bestehenden Anforderungen nicht durch eine einzige Cloud-Form erfüllen. Häufig ist also eine Entweder-oder-Entscheidung – Private oder Public – nicht ideal. Hybrid Clouds kombinieren verschiedene Cloud-Modelle und sind vor allem auch eine Lösung für die sogenannte Data Gravity. Der Begriff bedeutet, dass Daten unterschiedlich beweglich und manche träge sind. Gründe für diese Trägheit können die Datengrösse, eine erforderliche kurze Latenz beim Zugriff oder rechtliche Bedingungen bezüglich des Speicherorts sein. In einer Public Cloud lassen sich solche Daten daher nicht ohne Weiteres ablegen. Mit einem hybriden Cloud-Modell erweitert man seine Unternehmensressourcen dennoch dynamisch – ohne dass es erforderlich ist, die trägen Daten in einer Public Cloud abzulegen. Stattdessen greifen die Public-Cloud-Dienste bei Bedarf auf diese trägen Daten zu, die innerhalb des Unternehmens abgelegt bleiben.

Plattformbasierte Anwendungen

Der Cloud-Trend reicht aber noch weiter. Immer mehr Unternehmen verabschieden sich von ihren autonomen, standortgebundenen Software-Systemen und ersetzen sie durch globale Cloud-Plattformen. Sie erhalten so Zugang zu Software-Lösungen, die sich viele Unternehmen noch vor wenigen Jahren als On-Premise-Lösung nicht hätten leisten können.

Die IT-Plattformen in der Cloud sind dabei, die Geschäftswelt komplett zu verändern. Ein Beispiel: Ein Unternehmen, das eine mobile App mit diversen Anbindungen benötigt, etwa zu einem Shop oder einem Kurzmitteilungsdienst, muss heute nicht mehr Monate auf deren Entwicklung warten. Vielmehr sucht man sich aus diversen Cloud-Diensten die benötigten Module zusammen und erstellt die gewünschte App aus den Bausteinen.

Plattformbasierte Infrastrukturen und Anwendungen gehören laut Maik Hähnel von Axians zu den Top-Trends 2018: „Der Haupttrend, den wir sehen, sind die Themen, die Plattformen betreffen.“ Seiner Ansicht nach steht nicht zu erwarten, dass alle Unternehmen im kommenden Jahr ihre Systeme komplett auf die neuen Plattformen umstellen, „aber sie werden ihre IT-Strategie darauf ausrichten und die ersten Plattformen und notwendige Bestandteile einführen.“ Agilität in der Bereitstellung sowie serviceorientierte Planung und Abbildung gewännen in der IT immer mehr an Bedeutung. „Schon heute ist die Nachfrage hoch, vor allem in Unternehmen, die auf neue Software-Architekturen setzen.“

Plattform-Technologien für agile Entwicklungen und die Bereitstellung von Anwendungen stehen also hoch im Kurs. „Als Fazit könnte man sagen, dass die Bereitstellung von Plattformen für die Digitalisierung und agile Software-Entwicklung die Unternehmen am meisten umtreibt“, so Hähnel.

Security as a Service

Die Ransomware Wannacry hat Anfang dieses Jahres Hunderttausende Rechner infiziert und die IT-Welt gehörig aufgerüttelt. Ransomware verschlüsselt sämtliche Daten – sogar auf angeschlossenen Netzlaufwerken und eingebundenen Cloud-Diensten. Die Freigabe der Ressourcen erfolgt nur gegen Zahlung eines Lösegelds. Weil die Wiederherstellung der Daten häufig mit deutlich höheren Kosten verbunden wäre, entscheiden sich viele Unternehmen dafür, das Lösegeld zu zahlen. Oft sind die Kosten allerdings noch der geringste Schaden. Hinzu kommen Reputations- oder sogar Fremdschäden, etwa wenn es sich bei den verschlüsselten Daten um Kundendaten handelt und sich Aufträge nicht rechtzeitig erledigen lassen.

„Die Anzahl an Ransomware-Angriffen ist in den letzten drei Jahren definitiv stark angestiegen“, weiss Christian Funk, Leiter des deutschen Forschungs- und Analyse-Teams bei Kaspersky. Dabei gibt er aber zu bedenken: „Während klassische Trojaner unbemerkt im Hintergrund ihr Werk verrichten und entsprechend oft nie gefunden werden, steht Ransomware sofort im Rampenlicht.“ Dies steigere die Aufmerksamkeit zusätzlich.

“ „Die dominierenden IT-Themen aus dem Jahr 2017 werden den Markt auch weiterhin am meisten umtreiben.“„

Maik Hähnel

Chief Technology Officer

bei Vinci Energies

Deutschland ICT/Axians

www.vinci-energies.de

bei Vinci Energies

Deutschland ICT/Axians

www.vinci-energies.de

Dass die Gefahr von Ransomware weiterhin allgegenwärtig ist, bestätigt auch Candid Wüest, Principal Threat Researcher bei Symantec: „In diesem Jahr hat die Zahl der Infektionen durch Ransomware weiter zugenommen. Wir erwarten, dass sich dieser Trend 2018 fortsetzt.“ Allgemeingültige Aussagen, ob das auch die gefährlichste Bedrohung schlechthin für Unternehmen sei, lassen sich seiner Einschätzung nach aber nur schwer treffen, „denn die verschiedenen Branchen reagieren sehr unterschiedlich auf die Bedrohung und sind unterschiedlich stark betroffen.“ Ransomware wie Wannacry habe dem Thema tatsächlich eine breite öffentliche Aufmerksamkeit beschert.

„Mit der zunehmenden Vernetzung vergrössert sich zwangsläufig die Angriffsfläche“, resümiert Christian Funk die Sicherheitsgefahren im kommenden Jahr. Daher gelte es für Unternehmen und Organisationen in Zeiten von Industrie 4.0 und Internet of Things die Sicherheitsstellschrauben für kritische und Embedded-Systeme anzuziehen.

Aber nicht nur Ransomware ist ein wichtiges Thema, sondern allgemein die steigende Zahl an Cyberangriffen auf Unternehmen. Laut Felix Blank von Secucloud ist eines der Probleme, dass der Industriesektor per se eine sehr langfristig planende Branche ist. „Maschinen und Anlagen werden auf Laufzeiten von zehn Jahren und mehr ausgelegt, um überhaupt rentabel zu sein. Wartungsfenster und Produktivausfälle durch Änderungen müssen dabei auf ein Minimum reduziert werden.“ Mit der schnelllebigen IT- und IT-Security- Entwicklung sei dies kaum zu vereinbaren. Hinzu komme, dass für viele Industrie-Ingenieure auch heute noch die Funktionalität klar im Vordergrund stehe. Sein ernüchterndes Fazit: „Das Verständnis für IT-Security (…) muss erst noch entwickelt werden. Rein aus IT-Security-Sicht hinkt die Industrie-4.0-Branche dem Stand der klassischen Office-Welt um etwa fünf bis acht Jahre hinterher.“

Doch wie sollen Unternehmen den wachsenden Bedrohungen begegnen? Candid Wüest von Symantec stimmt zwar zu, dass die Angriffsmöglichkeiten angesichts der immer vielfältiger werdenden Technologien weiter zunehmen. Unbeherrschbar werde die IT-Sicherheit für Unternehmen dadurch nicht. „Es gilt jedoch, die Sicherheitsvorkehrungen kontinuierlich weiterzuentwickeln.“ Aus seiner Sicht werden im kommenden Jahr unter anderem verhaltensbasierte Schutzlösungen eine grössere Rolle spielen. Dabei dürfte besonders auch User Entity Behavior Analytics verstärkt zum Einsatz kommen. Hier wird das Verhalten von Benutzern mit dem Ziel analysiert, Attacken auf IT-Systeme und den Diebstahl von Daten durch externe und interne Angreifer frühzeitig zu erkennen und zu unterbinden. Diese Analysesysteme verwenden spezielle Algorithmen und Machine-Learning-Verfahren, mit denen typische Verhaltensmuster von IT-Nutzern ermittelt und analysiert werden.

“„In diesem Jahr hat die Zahl der Infektionen durch Ransomware weiter zugenommen. Wir erwarten, dass sich dieser Trend 2018 fortsetzt.“ „

Der Trend in der IT-Sicherheit geht – wie in vielen Bereichen der IT – in Richtung Cloud und „as a Service“ und wird, wie von Candid Wüest angesprochen, mit Hilfe von Machine-Learning-Verfahren immer weiter verbessert. Felix Blank ergänzt: „Der ,Gartner Hype Cycle for Midsize Enterprises 2017‘ beinhaltet als neue Security-Technik die Firewall as a Service (FWaaS). Eine Firewall wird als Cloud-Dienst bereitgestellt und ist damit immer aktuell sowie unbegrenzt skalierbar. Ganz in diesem Sinne wird auch IT-Security generell immer mehr zum Service werden.“

Firmen fangen vermehrt damit an, die IT-Sicherheit als Dienstleistung einzukaufen, Managed Security Services (MSS) genannt. Es gibt allerdings keine allgemeingültige Definition, was genau ein MSS ist. Dahinter können sich vielfältige Dienstleistungen rund um das Thema Sicherheit verbergen, von unterstützenden Services bei Penetrationstests bis hin zur vollständigen Bereitstellung von Sicherheitsinfrastrukturen wie Firewalls oder Virtual Private Networks.

Virtual Reality und Augmented Reality

Virtuelle Realität wird in den kommenden Monaten und Jahren viele Prozesse in Unternehmen verändern und effizienter machen. Betroffen sind alle Bereiche – von der Logistik über Service und Wartung bis hin zur Fertigung. Hinzu kommt, dass virtuelle Realität ganz neue Geschäftsmodelle und Produkte ermöglicht.

Bei virtueller Realität unterscheidet man zwischen zwei Technologien: Augmented Reality (AR), also erweiterte Realität, ist eine Kombination aus wahrgenommener und vom Computer erzeugter Realität. Anders als bei virtueller Realität (Virtual Reality, VR) geht es bei Augmented Reality darum, die realen Wahrnehmungen mit Zusatzinformationen zu ergänzen. Alle Systeme, welche die natürliche Wahrnehmung mit einer künstlichen vermischen, fasst man unter dem Begriff Mixed Reality zusammen.

Neu sind die Techniken VR und AR freilich nicht. Was sich verändert hat, ist die Massenverfügbarkeit. Noch vor zwei Jahren war die Technologie komplex und teuer. Heute gibt es bezahlbare VR-Brillen für jedermann.

Laut Maik Hähnel von Axians ist der Markt im Bereich Virtual und Augmented Reality schwer einzuschätzen: „Der Nutzen solcher Lösungen lässt sich zwar klar darstellen, es gilt jedoch, pro Kunde und Branche das richtige Einsatzszenario zu definieren – und das ist nicht immer einfach.“

Beispiele für den erfolgreichen Einsatz von virtueller Realität im Unternehmensumfeld und für die Generierung neuer Geschäftsmodelle und Produkte gibt es zuhauf. Das Fraunhofer-Institut für Fabrikbetrieb und -automatisierung IFF bietet etwa mit dem Elbedome ein Mixed-Reality-Labor an. Eine 360-Grad-Projektionsfläche mit über 300 Quadratmetern und sechs Laserprojektoren stellt grosse Objekte wie Maschinen und Anlagen oder ganze Fabriken und Städte im Massstab 1:1 dar. Der Elbedome eignet sich, um Anlagen- und Fabriklayouts zu konzeptionieren, aber auch für die Stadt- und Architekturplanung.

Bei der Post-Tochter DHL Supply Chain gehören Augmented-Reality-gestützte Datenbrillen bereits zur Standardausrüstung in den Lagern weltweit. Nach Pilotprojekten auf der ganzen Welt blenden nun bei allen Mitarbeitern in der Waren-Kommissionierung Datenbrillen Arbeitsanweisungen und Hinweise ein, etwa wo sich ein gesuchter Artikel befindet und wo er auf dem Wagen zu positionieren ist. Laut DHL steigern die Brillen die Produktivität um rund 15 Prozent – bei gleichzeitig sinkender Fehlerquote.

Der Freizeitpark Europa-Park in Rust hat vor rund eineinhalb Jahren die digitale Variante einer Achterbahn vorgestellt: Auf dem Alpenexpress Coastiality wird mit Hilfe einer VR-Brille vor den Augen der Fahrgäste eine Fantasiewelt erzeugt, während gleichzeitig die reale Achterbahnfahrt – also Fahrtwind, Fliehkräfte und Kurven – spürbar bleibt. Während der Fahrt sehen die Nutzer vor ihren Augen eine virtuelle 3D-Welt, die perfekt auf die Bahn abgestimmt ist.

5G und das Internet der Dinge

Die Vernetzung von Dingen wie Autos oder Produktionsmaschinen im Internet der Dinge (IoT) nimmt rasant zu. Die Analysten von Gartner gehen bis zum Jahr 2020 von weltweit über 20 Milliarden vernetzten IoT-Geräten aus. Die Verbindung dieser Geräte erfordert leistungsfähige Netzwerke.

Diese Aufgabe soll der künftige Mobilfunkstandard 5G übernehmen. Während der aktuelle Standard LTE/4G derzeit Übertragungsraten von bis zu 500 MBit/s schafft, künftig sollen bis zu 1 GBit/s möglich sein, verspricht 5G Datenraten von bis zu 20 GBit/s – genug Bandbreite, um die vielen vernetzten Geräte ohne Engpässe zu verbinden. Erst mit 5G soll sich alles, was digitalisiert wird, auch vernetzen lassen. Der neue Standard bildet quasi die Grundlage für Industrie 4.0. „5G wird vor allem bei Telekommunikationsunternehmen und im Bereich Infrastrukturausbau das dominierende Thema sein“, ist sich Maik Hähnel von Axians sicher.

Übertragungsgeschwindigkeiten von bis zu 20 GBit/s eröffnen zahlreiche neue Anwendungsmöglichkeiten. So lassen sich zum Beispiel Techniken wie Augmented Reality, Virtual Reality oder Ultra-HD-Streaming mit 5G auch mobil nutzen. Und die Telekommunikationsbranche gibt beim Thema 5G auch ordentlich Gas. 2020 sollen erstmals Daten durch die neuen 5G-Netze fliessen. Auch für viele Unternehmen heisst es daher, sich auf den kommenden Standard vorzubereiten und dafür zu sorgen, dass bei Marktstart entsprechende Dienste und Produkte zur Verfügung stehen.

IoT-Plattformen

Wie erwähnt geht Gartner bis 2020 von weltweit über 20 Milliarden vernetzten IoT-Geräten aus. Am Internet der Dinge führt auch laut Cancom-CEO Klaus Weinmann in nächster Zeit kein Weg vorbei. Die Zahl cloudbasierter IoT-Plattformen für die Vernetzung und Verwaltung von Sensoren sowie der generierten Daten wird deutlich zunehmen.

“„Das Verständnis für IT-Security muss erst noch entwickelt werden. Rein aus IT-Security-Sicht hinkt die Industrie-4.0-Branche dem Stand der klassischen Office-Welt um etwa fünf bis acht Jahre hinterher.“„

Das Problem: Schon jetzt ist das Angebot an IoT-Plattformen gross. Bei genauerem Hinsehen zeigt sich jedoch, dass unter dieser Bezeichnung ganz unterschiedliche Produkte vermarktet werden. Nicht immer ist sofort erkennbar, ob es sich dabei tatsächlich um eine voll funktionale, ausgereifte IoT-Cloud-Plattform handelt oder ob sich der Begriff nur auf ein einziges Element einer Plattform bezieht. Eine vollständige IoT-Plattform umfasst zahlreiche Komponenten – von der Konnektivität über das Gerätemanagement, Datenbanken, Analytics und Datenvisualisierung bis hin zu zusätzlichen Werkzeugen, etwa der Integration von Drittanbietersystemen. „Standards für IoT-Plattformen werden sicher eine Weile auf sich warten lassen, zu neu ist der Bereich, zu weit gefächert sind Ideen und Marktpositionierungen“, so die Einschätzung von Maik Hähnel von Axians.

Cognitive Computing

Wenn es nach den Analysten von IDC geht, dann übernimmt die Künstliche Intelligenz (KI), auch Cognitive Computing genannt, die Regie in vielen Bereichen der IT und damit auch des täglichen Lebens. So sollen bis 2019 rund 40 Prozent aller Digitalisierungsprojekte und 100 Prozent der IoT-Massnahmen durch Funktionen mit KI unterstützt werden. Die Managementberatung Accenture prognostiziert für Deutschland durch den Einsatz von Künstlicher Intelligenz bis 2035 einen Anstieg des Wirtschaftswachstums um jährlich 3 Prozent. Zudem werde die Produktivität der Beschäftigten hierzulande um 29 Prozent steigen, da Arbeitsabläufe effizienter gestaltet würden.

„Machine Learning und Deep Learning werden auf jeden Fall im Markt ankommen“, ist sich auch Bernhard Kube von Lufthansa sicher, vor allem im Bereich der Datenanalyse. Die Welt ertrinkt förmlich in Daten. Kein noch so grosses Team von Analytikern wäre in der Lage, aus dieser Flut noch brauchbare Informationen zu isolieren. Das Sammeln und Verarbeiten von Daten ist daher eine grosse Herausforderung für Unternehmen – aber gleichzeitig auch von höchster Wichtigkeit. Denn diese Daten bilden eine wichtige Entscheidungsgrundlage für die gezielte Weiterentwicklung von Geschäftsmodellen, Produkten und Marken. „Deep Learning wird eine Standardmethode im Methodenkanon der Data Science.“ Ähnlich sieht es Cancom-CEO Klaus Weinmann: „Immer bessere Technologien aus den Bereichen Machine Learning und Business Intelligence analysieren gigantische Datenmengen und werten diese aus.“

Nicht nur im Bereich der Datenanalyse setzt sich die Künstliche Intelligenz immer mehr durch. Im Juli dieses Jahres hat im japanischen Sasebo in einem Freizeitpark ein Hotel eröffnet, das fast komplett von Robotern betrieben wird. Das Hauptziel des Hotels ist es, möglichst viel Komfort für wenig Geld anzubieten. Die Roboter sind dabei ein wichtiger Baustein zur Kostenreduzierung. Sie werden unter anderem an der Rezeption, als Gepäckträger oder beim Reinigen eingesetzt.

Process Mining

Einer der grossen Trends bei der Datenanalyse ist das Process Mining. Die Visualisierung von Unternehmensprozessen zeigt, wo es Optimierungsbedarf gibt und wo es hakt. Bernhard Kube von Lufthansa Industry Solutions bestätigt: „Process Mining wird zunehmend nachgefragt.“

In jedem Unternehmen gibt es zig Prozesse, die tagtäglich ablaufen: Es gehen zum Beispiel Bestellungen ein, Lieferungen verlassen das Haus, Rechnungen werden geschrieben und bezahlt. Unternehmen haben für den Ablauf dieser Prozesse meist feste Regeln: So müssen etwa Rechnungen, bevor sie von der Buchhaltung beglichen werden, von einer Fachabteilung geprüft und abgesegnet werden. Das Problem dabei: Je umfangreicher ein Prozess ist, desto grösser ist die Gefahr, dass sich Fehler einschleichen. Hinzu kommt, dass diese Prozesse oft ganz anders ablaufen, als die Mitarbeiter meinen – und vieles doch nicht so geschmeidig funktioniert wie gedacht.

Hier kommt das Process Mining ins Spiel: Ein Workflow-System hält die digitalen Spuren fest, die jeder Schritt eines Prozesses produziert, also im Lager oder in der Buchhaltung. Die digitalen Spuren entstehen etwa in betriebswirtschaftlichen Systemen wie denen von SAP. Unter Anwendung des Process Minings können unterschiedliche Aspekte eines Prozesses berücksichtigt werden, um Schwachstellen aufzuzeigen.