KI lokal nutzen

TinyLlama

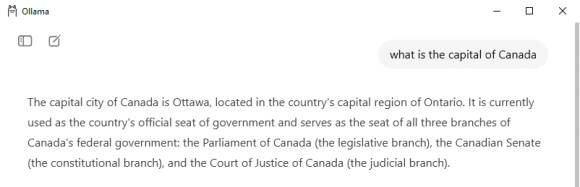

Auf der Webseite ollama.com/library finden Sie wie bereits erwähnt die lange Liste der Modelle, die Ollama unterstützt. Wenn Sie eines der Modelle anklicken, erhalten Sie ausführliche Informationen dazu. TinyLlama ist eines der schnellsten LLMs, die man auf langsameren Rechnern ausführen kann. Auch wenn es nicht so hochwertige Ergebnisse liefert wie grössere Modelle, ist es dennoch in der Lage, einfache Fragen zu beantworten. Was TinyLlama an Qualität vermissen lässt, macht es durch seine Schnelligkeit wieder wett, Bild 11. Um es herunterzuladen und danach auszuführen, geben Sie einfach den Befehl ollama pull tinyllama und danach ollama run tinyllama in der Windows-Eingabeaufforderung ein. Der Download dauert nicht lange, da er nur rund 600 MB gross ist.

Bild 11: Tinyllama ist ein vergleichsweise winziges KI-Modell, das dennoch brauchbare und vor allem schnelle Antworten liefert

Quelle: PCtipp.ch