KI-Tipps

02.12.2025, 12:00 Uhr

KI lokal nutzen

Wenn Sie eine künstliche Intelligenz lokal installieren, verbleiben die Daten bei Ihnen und werden nicht Teil des Trainings der KI. Dieser Artikel erklärt, wie sich mehrere KIs schnell lokal installieren und nutzen lassen.

(Quelle: Shutterstock AI)

Trainingsdaten sind der Treibstoff für KI-Systeme. Sie bestehen aus einer riesigen Menge an Bildern und Texten. Da die Daten aus dem Internet weitgehend abgegrast sind, suchen sich die KI-Konzerne wie OpenAI, Microsoft, Google und Meta neue Datenquellen, mit denen sie ihre datenhungrigen Modelle füttern können. Immer mehr rücken dabei auch private Daten ins Visier: Beiträge und Bilder auf Facebook, öffentlich zugängliche Dokumente von Google Docs oder eben Daten, die Sie bei der Nutzung einer KI preisgeben.

Wenn Sie mit einer KI wie ChatGPT kommunizieren, gibt es immer auch einen Rückkanal. Informationen fliessen an den Anbieter zurück und dienen künftig womöglich als Trainingsmaterial. Gerichtlich ist diese Praxis bisher nicht abschliessend bewertet. Denn beim Training kommen urheberrechtlich geschützte Werke ebenso wie Firmengeheimnisse und sensible private Daten in das Mahlwerk der KI. Nur bei lokal installierten Offline-KIs können Sie sicher sein, dass keinerlei private Daten abfliessen. So unterbinden Sie, dass der Anbieter erfährt, welche Prompts Sie verwenden, was Sie generieren lassen und welche Daten Sie dafür zur Verfügung stellen. Zudem sind keine teuren Abonnements nötig und Sie unterliegen keinen Begrenzungen. Dank cleverer Tools gelingt die Installation lokaler KI-Modelle mühelos, wie Sie auf den folgenden Seiten erfahren werden.

Voraussetzungen

Bei einer lokalen KI fallen drei PC-Komponenten besonders ins Gewicht. Das erste ist die Grafikkarte. Nvidia-Grafikkarten haben hier die Nase vorn, mit AMD klappt es inzwischen aber auch ganz gut. Es kommt zudem auf den Grafikspeicher an. Grundsätzlich gilt: Viel hilft viel. 4 GB sollten es mindestens sein.

Die zweite Komponente ist der Arbeitsspeicher. Auch hier gilt: Je mehr, desto besser. Die Untergrenze stellen 32 GB dar.

Schliesslich benötigen Sie auch viel Speicherplatz, am besten auf einem schnellen NVMe-SSD (Nonvolatile Memory Express). Das sind die aktuell flinksten SSD-Datenträger, die aussehen wie RAM-Riegel. Sie sind deutlich rasanter als als ältere SATA-SSDs.

Die gute Nachricht, falls Sie keine leistungsstarke Hardware haben: Es gibt viele vereinfachte KI-Modelle, die auch auf alter Hardware passabel laufen. Wenn Ihre Grafikkarte sehr langsam ist, lassen sich manche Modelle zudem allein mit der CPU ausführen. Auch darauf gehen wir später ein.

Die Theorie hinter den abgespeckten Modellen: Ein KI-Modell basiert auf numerischen Koeffizienten, welche die Funktion jedes Neurons im Netzwerk beschreiben. Das Training des Modells berechnet die Gewichtungen und speichert sie als hochgenaue Bruchzahlen. Es stellte sich heraus, dass das Runden dieser Bruchzahlen im trainierten Modell es ermöglicht, das KI-Modell auf normalen Computern auszuführen, wobei sich die Leistung nur geringfügig verringert. Dieser Rundungsvorgang nennt sich Quantisierung. Damit lassen sich die Grösse und die Hardware-Ansprüche des Modells erheblich reduzieren.

Es gibt mehrere Tools, mit denen sich KI-Modelle bequem auf dem eigenen Rechner installieren lassen. Alle haben ihre Vorzüge und Nachteile. Machen Sie sich im Folgenden am besten selbst ein Bild.

Hinweis: Bei vielen aktuellen KI-Modellen kommen Sie mit englischen Texteingaben am besten zum Ziel. Falls Sie Hilfe beim Übersetzen brauchen, ist ein digitaler Dolmetscher wie deepl.com sehr nützlich.

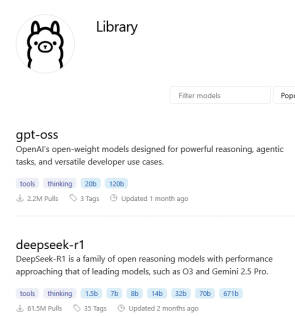

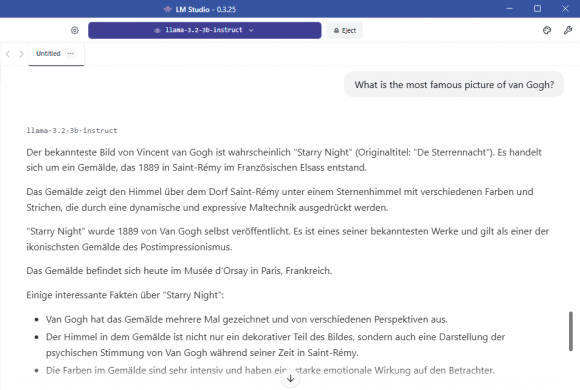

LM Studio

LM Studio ermöglicht es Ihnen, diverse KI-Modelle wie Llama, Mistral und Phi auf dem eigenen Rechner auszuführen. Auch die kürzlich von OpenAI veröffentlichten Varianten von ChatGPT gehören dazu, ebenso DeepSeek aus China. Wählen Sie die am besten geeigneten Modelle für Ihre jeweiligen Aufgaben. Neben der reinen Chatfunktion können Sie auch lokale Dokumente einbinden und analysieren lassen.

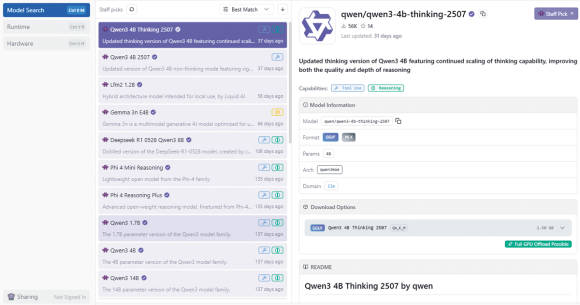

Surfen Sie zu der Website lmstudio.ai, laden Sie LM Studio herunter und installieren Sie es. Nach dem ersten Start sind noch keine Modelle vorhanden. Klicken Sie auf das Lupen-Symbol, um zu einer Liste der verfügbaren Modelle zu gelangen. Sie ist sehr lang, Bild 1.

Bild 1: LM Studio kennt unzählige KI-Modelle, die sich sogleich herunterladen lassen

Quelle: PCtipp.ch

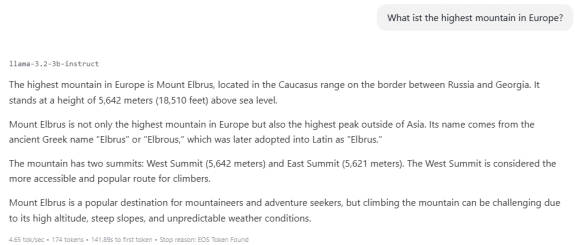

Bild 2: Llama 3.2 von Meta ist ein fortschrittliches KI-Modell, das auf Fragen sehr ausführlich antwortet

Quelle: PCtipp.ch

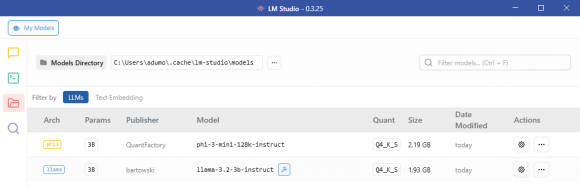

Bild 3: Unter My Models sehen Sie, welche Modelle installiert sind, und in welchem Ordner sie sich befinden

Quelle: PCtipp.ch

Bild 4: LM Studio stellt eine Bedienoberfläche bereit, in der Sie mit dem ausgewählten KI-Modell kommunizieren

Quelle: PCtipp.ch

Um weitere Modelle zu installieren, klicken Sie auf den Button mit dem Lupen-Symbol. In der Liste der empfohlenen Modelle befindet sich auch DeepSeek-R1-0528-Qwen3-8B.

Dabei handelt es sich um ein Distill-Modell. KI-Distillation ist ein Verfahren, bei dem das Wissen grosser KI-Modelle (Lehrermodelle) auf kleinere, effizientere Modelle (Schülermodelle) übertragen wird. Ziel ist es, die Leistung der grossen Modelle zu bewahren und gleichzeitig Rechenaufwand, Energieverbrauch und Hardware-Anforderungen drastisch zu reduzieren. Dennoch schlägt das Modell mit rund 5 GB zu Buche.

Weitere gute Modelle sind Phi, Hermes und Mistral. Sie stehen in zahlreichen Versionen zur Verfügung. Schauen Sie, welche am besten zu Ihrer Hardware passt. Ein vergleichsweise anspruchsloses Modell ist zum Beispiel Phi-3-mini-128k-instruct-GGUF mit gut 2 GB. Über das lilafarbene Feld am Seitenkopf wählen Sie aus, welches Modell Sie aktuell verwenden wollen. Wenn Sie in das Suchfeld GPT eingeben, finden Sie auch die OpenAI-Modelle gpt-oss-20b-GGUF und gpt-oss-120b-GGUF. Ersteres kommt auf 12 GB, letzteres auf 62 GB. Der Einsatz ergibt nur auf leistungsstarken Rechnern einen Sinn.

Llamafile

Llamafile beschreitet einen etwas anderen Weg. Das Tool ermöglicht es, KI-Modelle in einer einzigen ausführbaren Datei zu verpacken und lokal und damit komplett anonym auf dem eigenen Computer zu nutzen. Anders gesagt: Llamafile kann die öffentlich verfügbaren Gewichte von grossen Sprachmodellen in eine ausführbare Datei konvertieren.

Das klingt unspektakulär, eröffnet aber ungeahnte Möglichkeiten. Die Gewichte, die bei den Open-Source-Modellen meist frei verfügbar sind, sind vereinfacht gesagt die Parameter oder Einstellungen des Modells, die dafür sorgen, dass es gute Antworten gibt. Es handelt sich dabei in der Regel um riesige Dateien, die man so nicht einfach benutzen kann.

Es gibt mehrere Möglichkeiten, wie man die KI-Modelle mit Llamafile verwenden kann. Direkt auf der GitHub-Seite von Llamafile finden Sie unter dem Abschnitt Quickstart die einfachste Möglichkeit: Sie können hier eine fertige Datei, ein Llamafile, herunterladen und direkt ausführen, um die KI zu nutzen.

Surfen Sie zu github.com/Mozilla-Ocho/llamafile und laden Sie etwa das Modell Gemma 3 1B Instruct herunter. Die dazugehörige Datei heisst google_gemma-3-1b-it.Q6_K.llamafile. Ändern Sie den Dateinamen, indem Sie ein .exe anhängen. Öffnen Sie die Eingabeaufforderung: Drücken Sie Windowstaste+R, geben Sie cmd in das Ausführen-Feld ein und drücken Sie Enter. Dort navigieren Sie zum Llamafile, indem Sie cd C:\Users\[IhrBenutzername]\Downloads eingeben. Rufen Sie das File mit folgendem Befehl auf: .\google_gemma-3-1b-it-Q6_K.llamafile.exe

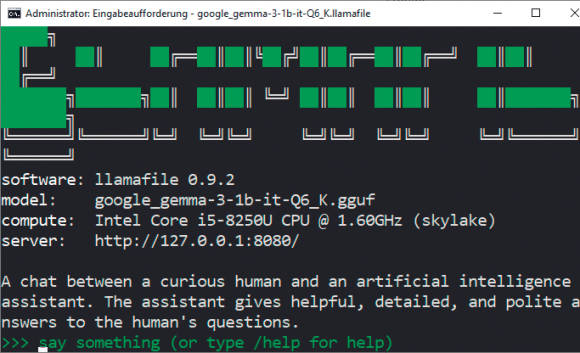

Nach einigen Sekunden startet das Modell in der Eingabeaufforderung, Bild 5. Sie können es ausserdem im Webbrowser via http://localhost:8080 nutzen. Tragen Sie zum Beispiel im Webbrowser Ihre Frage wie «What is the capital of Bolivia?» in das Eingabefeld ein und klicken auf Send. Gemma benötigt wenige Ressourcen und liefert sofort eine Antwort, ist aber nicht immer aktuell. Zum Beenden verwenden Sie in der Eingabeaufforderung die Tastenkombination Ctrl+C, Bild 6.

Bild 5: Llamafiles laufen in der Eingabeaufforderung und lassen sich auch dort bedienen

Quelle: PCtipp.ch

Bild 6: Llamafiles sind KI-Modelle als ausführbare Dateien; sie lassen sich bequem im Browser bedienen

Quelle: PCtipp.ch

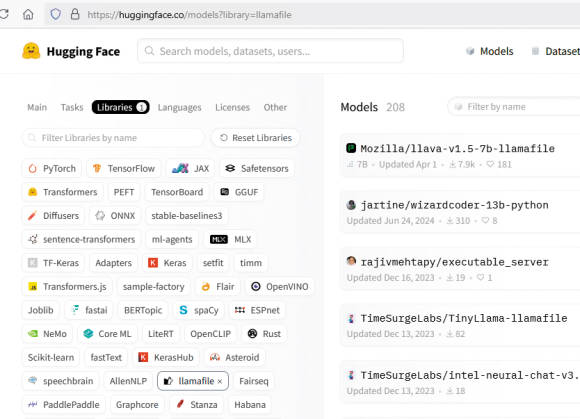

Bild 7: Auf der Webseite von Hugging Face stehen mehr als 200 Llamafiles bereit

Quelle: PCtipp.ch

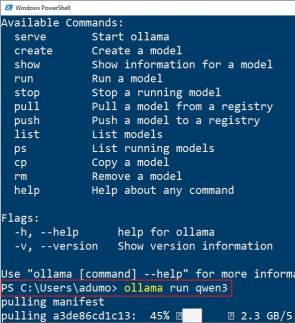

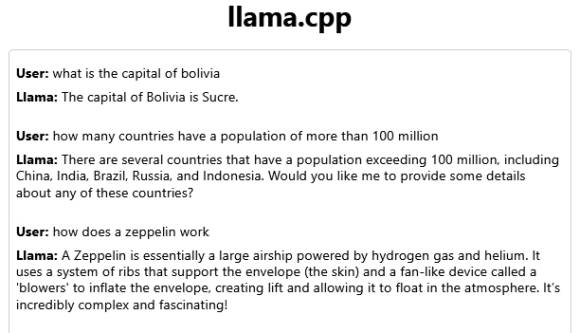

Ollama

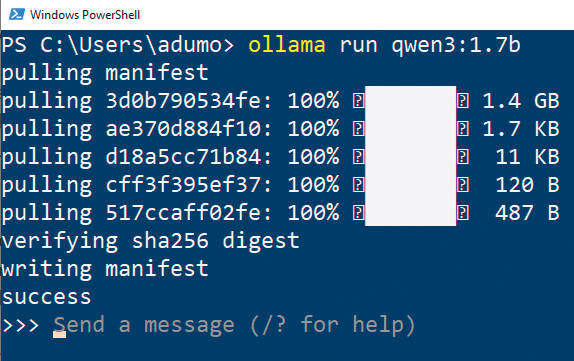

Bild 8: Um ein Modell auszuführen, geben Sie ollama run ein, gefolgt vom Modellnamen

Quelle: PCtipp.ch

Bild 9: Bei Ollama sehen Sie auf einen Blick, welche Modellvarianten zur Verfügung stehen

Quelle: PCtipp.ch

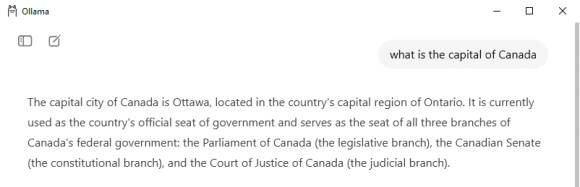

Bild 10: Der Chat erfolgt in der Windows-Eingabeaufforderung oder in der Bedienoberfläche von Ollama

Quelle: PCtipp.ch

TinyLlama

Auf der Webseite ollama.com/library finden Sie wie bereits erwähnt die lange Liste der Modelle, die Ollama unterstützt. Wenn Sie eines der Modelle anklicken, erhalten Sie ausführliche Informationen dazu. TinyLlama ist eines der schnellsten LLMs, die man auf langsameren Rechnern ausführen kann. Auch wenn es nicht so hochwertige Ergebnisse liefert wie grössere Modelle, ist es dennoch in der Lage, einfache Fragen zu beantworten. Was TinyLlama an Qualität vermissen lässt, macht es durch seine Schnelligkeit wieder wett, Bild 11. Um es herunterzuladen und danach auszuführen, geben Sie einfach den Befehl ollama pull tinyllama und danach ollama run tinyllama in der Windows-Eingabeaufforderung ein. Der Download dauert nicht lange, da er nur rund 600 MB gross ist.

Bild 11: Tinyllama ist ein vergleichsweise winziges KI-Modell, das dennoch brauchbare und vor allem schnelle Antworten liefert

Quelle: PCtipp.ch

DeepSeek

DeepSeek gilt als ähnlich leistungsfähig wie ChatGPT. Es kommt zwar aus China, bei einer lokalen Installation spielt das aber keine Rolle. Allerdings benötigt das vollständige Modell mit 671 Milliarden Parametern über 400 GB Speicherplatz. Es bieten sich stattdessen abgespeckte Modelle mit eineinhalb, sieben oder acht Milliarden Parametern an. Die Installation erfolgt in gewohnter Manier mit: ollama pull deepseek-r1:1.5b

Auch aufeinander aufbauende Fragen sind möglich: Wenn Sie nach dem berühmtesten Bild von van Gogh fragen, erhalten Sie Starry night samt Entstehungsgeschichte als Antwort. Wenn Sie danach describe it als Prompt eingeben, weiss DeepSeek, was Sie meinen, und beschreibt Starry night.

Um die installierten Modelle zu entfernen, löschen Sie einfach den Inhalt des Ordners .ollama\models im Benutzerverzeichnis unter C:\Benutzer\[Ihr Benutzername] oder C:\Users\[Ihr Benutzername]. Die Modelle von LM Studio liegen dort unter dem Pfad .cache\lm-studio\models.