AI-Bibliothek für Android und iOS

15.11.2017, 16:59 Uhr

Google präsentiert TensorFlow Lite

Google hat eine leichtgewichtige Version seiner AI-Bibliothek TensorFlow für mobile Geräte und Embedded-Systeme entwickelt. Die Lite-Variante soll für niedrigere Latenzen und hohe Performance bei On-Device-Machine-Learning sorgen.

Das TensorFlow-Projekt von Google will Entwicklern eine performante Basis für Machine-Learning-Lösungen zur Verfügung stellen. Jetzt haben die Kalifornier eine spezielle Lite-Version der freien AI-Bibliothek vorgestellt, die für den Einsatz auf mobilen Geräten und Embedded-Systemen konzipiert wurde. Dank des schlanken Aufbaus verspricht die Lösung On-Device-Machine-Learning mit niedrigen Latenzen und hoher Leistung.

TensorFlow Light wurde laut Google von Grund auf neu entwickelt, um dank seiner geringen Grösse Inferencing bei On-Device-Machine-Learning zu ermöglichen. Dabei handelt es sich um das Ausführen bereits bekannter Modelle. Für das KI-Training ist die Lösung hingegen nicht vorgesehen. Darüber hinaus habe Google bei der Entwicklung besonderen Wert auf die Plattformunabhängigkeit gelegt. So ist TensorFlow Light etwa vom Start weg für Android und iOS erhältlich, wobei weitere Plattformen folgen sollen. Dank der Optimierung für mobile Geräte und Unterstützung von Hardwarebeschleunigung sollen Modelle zudem von wesentlich kürzeren Ladezeiten profitieren.

Unterstützung für optimierte Hardware

Dank des Supports für die Android Neural Networks API profitiert TensorFlow Light direkt von Hardware, die für Machine-Learning-Workloads optimiert wurde. Beispielsweise besitzen sowohl Qualcomms Snapdragon 835 als auch Huaweis Kirin 970 Co-Prozessoren für Machine-Learning. Und falls keine solche Hardware zur Verfügung steht, soll eine verbesserte CPU-Ausführung dennoch für hohe Performance sorgen.

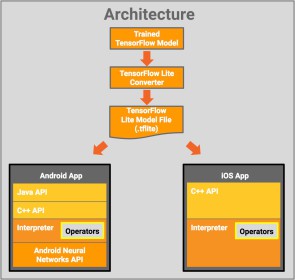

In der Praxis werden fertig trainierte TensorFlow-Modelle über einen Converter für die Ausführung unter mobilen Geräten optimiert. Auf Android- und iOS-Geräten kommen anschliessend je nach System Java und/oder C++ APIs zum Einsatz, um die Modell-Datei von einem Interpreter ausführen zu lassen.

Aktuell ist TensorFlow Light lediglich in einer Vorschauversion für Testzwecke erhältlich. Über einige fertig trainierte Modelle können Entwickler erste Erfahrungen mit der neuen Lösung sammeln.