Dark Theme und Datenschutz

10.05.2019, 11:51 Uhr

Googles Android Q orientiert sich am iPhone

Im Herbst kommt Googles Android Q. Die neue OS-Version bringt einige Änderungen, die unter anderem die Batterielaufzeiten von mobilen Geräten verlängern sollen. Ausserdem wird es eine Innovation geben, die erst durch maschinelles Lernen möglich wurde.

Das Besuchervotum bei der Vorstellung der neuen Android-Version Q war eindeutig: Der Dunkel-Modus, den Google "Dark Theme" nennt, erhielt bei der Entwicklerkonferenz Google I/O mit Abstand den meisten Beifall der rund 6000 anwesenden Entwickler.

Dabei geht es nicht nur um einen Designtrend, sondern ums Stromsparen. Zumindest bei Geräten mit OLED-Bildschirm werden die dunklen Pixel einfach ausgeknipst. Damit benötigt das Smartphone weniger Energie, und der Akku hält länger durch.

Der modische Dunkel-Modus, den Apple beim iPhone als Bedienungshilfe schon vor zwei Jahren eingeführt hat, soll bis zur Einführung des neuen Android-Betriebssystems im Herbst auch bei wichtigen Google-Anwendungen wie Gmail umgesetzt sein.

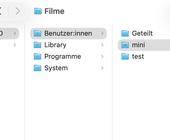

Auf der Google I/O in Mountain View in Kalifornien warb Google bei den Entwicklern dafür, auch ihre Apps entsprechend anzupassen, was über eine API relativ einfach umzusetzen ist. Der dunkle Modus kann in den Einstellungen unter dem Pfad Display/Design ausgewählt werden.

Diese neuen Werkzeuge bringt Android Q

Mit Wohlwollen wurde registriert, dass Google weiter am gesunden Gleichgewicht beim Umgang mit digitalen Geräten arbeitet. Mit Android Pie kamen bereits mit "Digital Wellbeing" eine Reihe von Werkzeugen wie das Dashboard und der App-Timer. Mit Q setzt Google diesen Kurs fort und gibt den Anwendern die Möglichkeit, zeitfressende Apps, die ständig um Aufmerksamkeit heischen, in den Hintergrund zu verbannen - etwa E-Mail oder Social-Media-Nachrichten. Der "Fokusmodus" soll die Anwender beim konzentrierten Arbeiten ohne Ablenkung unterstützen.

Bei Android Q zeigt Google auch, wie Menschen ohne Behinderung von Entwicklungen profitieren können, die für User mit Behinderung unternommen wurden. Die neue Funktion "Automatische Transkription" erkennt in Echtzeit gesprochene Worte, analysiert den Inhalt und blendet den Text als Untertitel ein - zum Beispiel unter einem Video, aber auch beim Abspielen eines Podcasts, einer Sprachnachricht oder beim Anhören einer eigenen Sprachaufnahme.

"Viele Software-Innovationen werden durch maschinelles Lernen direkt auf den Geräten vorangetrieben", sagte Google-Managerin Stephanie Cuthbertson. "Automatische Transkription" gehört dazu. Die Funktion sollte sich eigentlich an Gehörlose und Schwerhörige richten. Es stellte sich aber schnell heraus, dass auch Menschen ohne eine Hörbehinderung das Feature mögen - etwa wenn sie sich ein Video in einer Umgebung anschauen, in der man den Ton nicht abspielen will.