GitHub

31.08.2021, 08:54 Uhr

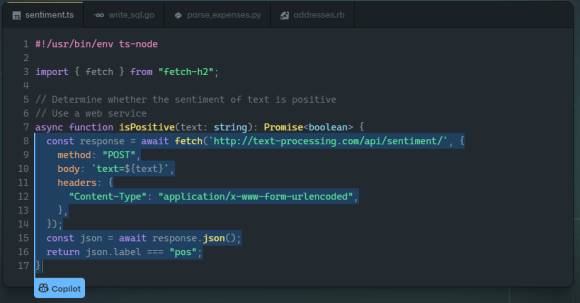

Copilot: Programmier-KI macht gravierende Fehler

Sicherheitsforscher haben den GitHub Copilot getestet und herausgefunden, dass dessen KI-Hilfen oft zu unsicheren Programmen führen.

Der neue GitHub Copilot zieht Kontext aus dem Code, an dem der Entwickler, den er begleitet, gerade arbeitet und schlägt ganze Zeilen oder Funktionen vor. Er soll dem begleiteten Entwickler dabei helfen schnell alternative Wege zur Problemlösung zu finden, Tests zu schreiben und neue APIs zu erforschen, ohne dass er dafür mühsam und langwierig im Internet nach Antworten suchen muss (mehr dazu hier).

Allerdings kann man von der KI nicht besonders viel erwarten, sagt eine empirische Evaluierung der Code-Beiträge von GitHub Copilot. Nach Meinung der Autoren der Evaluierung (Hammond Pearce, Baleegh Ahmad, Benjamin Tan, Brendan Dolan-Gavitt, Ramesh Karri) ist der Grund für die häufigen Fehler, die sie in ihrer empirischen Untersuchung festgestellt haben, schlicht darin zu suchen, dass das Sprachmodell von GitHub Copilot anhand von Open-Source-Code von GitHub trainiert wurde. Aber auch dieser Code enthält oft Fehler - und angesichts der riesigen Menge an ungeprüftem Code, welchen der Copilot verarbeitet hat, ist es nach Meindung der Autoren sicher, dass das Sprachmodell aus ausbeutbarem, fehlerhaftem Code gelernt hat.

Dies wirft Bedenken hinsichtlich der Sicherheit der Codebeiträge von Copilot auf. In dieser Arbeit untersuchen die oben genannten Autoren die Prävalenz und die Bedingungen, die GitHub Copilot dazu veranlassen können, unsicheren Code zu empfehlen.

Insgesamt wurden für die Untersuchung 89 verschiedene Szenarien für Copilot erstellt, aus denen 1.692 Programme hervorgingen. Von diesen Programmen erwiesen sich etwa 40 Prozent als anfällig.