Couchbase

23.03.2024, 09:00 Uhr

Vektorsuche für KI-gestützte, adaptive Anwendungen

Couchbase hat Vector Search für Edge Computing angekündigt. Damit sollen die Komplexität bei der Entwicklung adaptiver Applikationen reduziert, und Entwickler mit LangChain- und LlamaIndex-Support unterstützt werden.

Couchbase hat Vector Search als neues Feature in Couchbase Server und Couchbase Capella vorgestellt. Damit soll die Entwicklung KI-gestützter adaptiver Anwendungen für kontextbezogene und hyperpersonalisierte Services vereinfacht und beschleunigt werden. Als - nach Angaben des Herstellers - erste Datenbank-Plattform bietet Couchbase Vector Search für verschiedenste Szenarien an, von Rechenzentren über Cloud und Mobile Computing bis zu IoT-Devices am Edge. Adaptive Anwendungen können so überall eingesetzt werden.

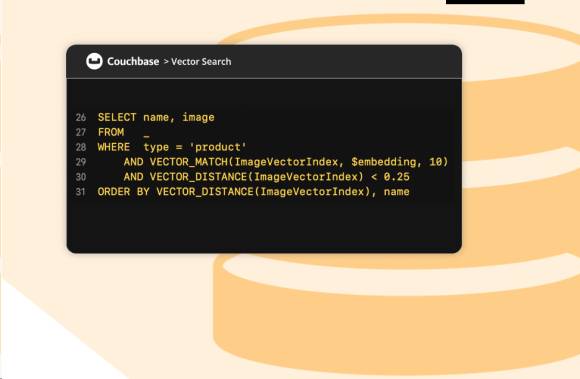

Typische Use Cases für adaptive Anwendungen sind beispielsweise Chatbots oder Semantic Search. Dafür werden hybride Suchfunktionen (Hybrid Search) benötigt, die unter anderem Texte, Vektoren, Tabellen und Lagerbestände durchsuchen. Vector Search ist in Verbindung mit Large Language Models (LLM) und Retrieval Augmented Generation (RAG) wichtig, um die Treffergenauigkeit zu erhöhen und Halluzinationen zu verhindern. Dafür reine Vector-Datenbanken einzusetzen, erhöht die Komplexität und beeinträchtigt die Performance der Applikationen. Couchbase beseitigt diese Einschränkungen durch die Integration von Vector Search in seine Multipurpose-Plattform und verbessert so die Qualität von LLM-Ergebnissen. Entwickler profitieren zudem von der Möglichkeit, SQL++-Queries für Vector Search bei der Applikations-Entwicklung zu nutzen.

Die neuen Features sollen im zweiten Quartal 2024 für Capella und Couchbase Server sowie als Beta-Version für mobil und Edge verfügbar sein. Mehr Informationen finden Sie unter https://www.couchbase.com.