Microsoft

20.10.2020, 20:48 Uhr

20.10.2020, 20:48 Uhr

Azure AI beschreibt Bilder genauso gut wie ein Mensch

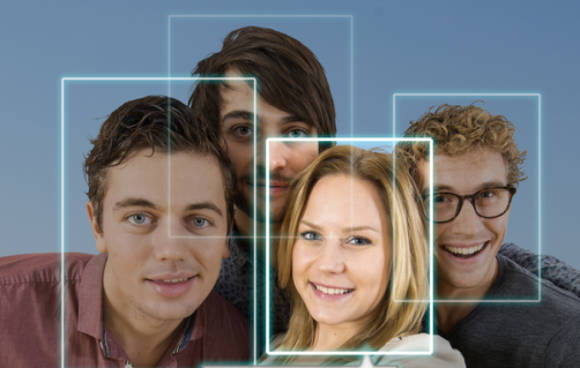

Um Bilder auch für Sehbehinderte oder Blinde zugänglich zu machen, hat Microsoft ein neues KI-System entwickelt, das automatisch Beschreibungen für Bilder erzeugt. In vielen Fällen sogar genauer als ein von Menschen gemachter sogenannter Alt-Text.

Das neue Feature steht über die Azure Cognitives Services zur Verfügung, die Teil der KI-Plattform von Azure sind und soll noch im Laufe dieses Jahres in Word und Outlook (Windows und OSX) sowie für PowerPoint (Windows, OSX und Web) integriert werden. Ausserdem soll ddie verbesserte Bildbeschreibungsfunktion zukünftig auch in Microsofts Kamera-App Seeing AI zum Einsatz kommen. Dort wird die Funktion verwendet, um Nutzern der Apps Fotos zu beschreiben.

Das Erfassen von Bildern ist eine zentrale Herausforderung in der Disziplin der Computervision, eine, die ein KI-System benötigt, um den Inhalt oder die Handlung in einem Bild zu verstehen und zu beschreiben, erklärt Lijuan Wang, leitende Forschungsmanagerin bei Microsoft Research. «Man muss wirklich verstehen, was vor sich geht, man muss die Beziehung zwischen Objekten und Aktionen kennen und man muss sie in einem Satz in natürlicher Sprache zusammenfassen und beschreiben», sagte sie. Wang leitete das Forschungsteam, das die menschliche Parität bei der neuartigen, massstabsgetreuen Objektbeschriftung (nocaps) erreichte - und übertroffen hat. Der Benchmark bewertet KI-Systeme danach, wie gut sie Untertitel für Objekte in Bildern erzeugen, die nicht in dem Datensatz enthalten sind, mit dem sie trainiert wurden.

Um die Herausforderung zu meistern, hat das Microsoft-Team ein grosses KI-Modell mit einem umfangreichen Datensatz von Bildern gepaart mit Wort-Tags trainiert, wobei jedes Tag einem bestimmten Objekt in einem Bild zugeordnet wurde. Datensätze von Bildern mit Wort-Tags anstelle von vollständigen Bildunterschriften sind effizienter zu erstellen, so dass das Team von Wang viele Daten in sein Modell einspeisen konnte. Der Ansatz durchdrang das Modell mit dem, was das Team ein visuelles Vokabular nennt.

Der Ansatz des visuellen Vokabulars vor dem Training, erklärt Xuedong Huang, CTO von Microsofts Azure AI Cognitive Services, ähnelt der Vorbereitung von Kindern auf das Lesen, indem zunächst ein Bilderbuch verwendet wird, das einzelne Wörter mit Bildern assoziiert, wie zum Beispiel ein Bild eines Apfels mit dem Wort «Apfel» darunter und ein Bild einer Katze mit dem Wort «Katze» darunter.

Das vortrainierte Modell wird dann für die Untertitelung auf dem Datensatz der mit Untertiteln versehenen Bilder verfeinert. In dieser Phase des Trainings lernt das Modell, wie man einen Satz verfasst. Wenn ihm ein Bild mit neuartigen Objekten präsentiert wird, nutzt das KI-System das visuelle Vokabular, um eine genaue Bildunterschrift zu generieren.

«Das System kombiniert das, was sowohl im Vortraining als auch in der Feinabstimmung gelernt wird, um mit neuartigen Objekten in der Prüfung umzugehen», sagt Wang.