SSDs in Rechenzentren

11.11.2015, 08:28 Uhr

Flash-Arrays sind schnell wie der Blitz

In Rechenzentren sind SSDs noch wenig verbreitet – doch das dürfte sich bald ändern, denn die Nachteile der Solid State Drives verschwinden mehr und mehr.

Schon seit den 70er-Jahren werden in Rechenzentren rotierende Speichermedien eingesetzt. Zuerst über proprietäre Schnittstellen, später über offene Standards wie IDE und SCSI. Die direkt an den Server angeschlossenen Laufwerke konnten die Kapazitäts- und Geschwindigkeitsanforderungen lange Zeit erfüllen. In den 1990ern entwickelten sich die ersten zentralisierten Speicherumgebungen. Der Datenhunger der Dotcom-Ära verlangte zentralisierte Speichersubsysteme, die flexibel erweitert werden konnten.

Die ohnehin schon hohen Storage-Anforderungen haben sich durch die Entwicklung der IT in den letzten 15 Jahren zusätzlich beschleunigt.

Intelligente Caching-Algorithmen, neue Schnittstellen und Bussysteme erlauben heute zwar, mehrere Petabyte Speicherplatz und Tausende Disks in einem Speichersubsystem zu skalieren, doch die Grenzen des rotierenden Mediums sind geblieben. Mit der Seagate Cheetah 15X aus dem Jahr 2000, der ersten Festplatte mit 15.000 Umdrehungen pro Minute, wurde die letzte Verbesserung erreicht. Seither stagniert die maximale Geschwindigkeit (IOPS, Input/Output operations Per Second) pro Medium. Durch die Verdichtung der 15K-Festplatten hat sich die Performance pro Gigabyte sogar massiv verschlechtert.

Zeit ist Geld

Die Flash-Technologie bietet hier aufgrund der hohen Geschwindigkeit einen adäquaten Lösungsansatz. Denn All-Flash-Arrays sind in erster Linie sehr schnell. Der Endnutzer kann mit sofort ausgeführten Suchanfragen rechnen. Alle Workloads lassen sich massiv beschleunigen.

Wenn beispielsweise ein Inventarbericht umgehend und täglich erstellt werden kann statt nur einmal pro Woche, dann hat das einen positiven Einfluss auf den Geschäftsablauf – Entscheidungen können einfach viel schneller und präziser getroffen werden. Flash-Arrays reduzieren überdies die Komplexität im Rechenzentrum und erlauben, personelle Ressourcen innovativ und optimal einzusetzen.

Bis jetzt hatte Flash-Speicher aber nicht den gleichen Stellenwert im Rechenzentrum wie herkömmliche Festplatten. Das hat mehrere Gründe:

- Erstens: Flash war lange Zeit zu teuer und liess sich deshalb nur für Applikationen mit sehr hohen Performance-Anforderungen rechtfertigen.

- Zweitens: Flash bot nicht die nötige Skalierbarkeit. Im Rechenzentrum werden Hunderte von Terabyte gefordert.

- Und drittens: Es mussten neue, für SSDs optimierte Betriebssysteme entwickelt werden. Algorithmen für rotierende Disks senken die Lebensdauer und Verfügbarkeit eines Flash-Arrays.

Anforderungen an Flash-Arrays im Unternehmen

Folgende Anforderungen muss ein All-Flash-Array erfüllen, um unternehmenstauglich zu sein.

Inline-Datenreduktion: Um die Kosten gegenüber traditionellen Disk-Subsystemen zu reduzieren, muss das All-Flash-Speichersystem mehrere Datenreduktionsverfahren aufweisen: globale Deduplizierung, Kompression und Thin Provisioning.

Die Effizienz der globalen Deduplizierung steigt, wenn möglichst kleine Blockgrössen erkannt werden – die kleinste Grösse liegt hier bei 512 Byte.

Bei der Kompression ist es genau umgekehrt: Je grösser die verwendete Blockgrösse, desto effizienter das Verfahren (32 KByte oder höher).

Durch die gegensätzlichen Anforderungen bringt eine adaptive Blockgrösse zwischen 512 Byte und 128 KByte die mit Abstand beste Datenreduktion.

Die Datenreduktionsverfahren müssen so integriert sein, dass sie nicht deaktiviert werden können. Anders als bei traditionellen Disk-Subsystemen, bei denen diese Technologien die Leistung negativ beeinflussen, kann ein All-Flash-Array damit höhere Leistung und Langlebigkeit sicherstellen.

Zuverlässigkeit: Um den Anforderungen eines Unternehmens mit 24/7-Betrieb gerecht zu werden, muss ein All-Flash-Array eine sehr hohe Verfügbarkeit aufweisen, ausserdem redundante Hardware-Komponenten haben und Fehler selbst beheben können. Die traditionellen RAID-Verfahren wurden für rotierende Disks geschrieben. Sie sollten nicht auf SSDs angewendet werden, da sie deren Lebenszyklus massiv reduzieren.

Hingegen erreicht jeder Hersteller, der ein SSD-freundliches RAID geschrieben hat, eine grössere Verfügbarkeit und Langlebigkeit als bei rotierenden Speichermedien.

Skalierbarkeit: Für ein Unternehmen ist Skalierbarkeit essenziell. Ein All-Flash-Array muss deshalb auf mehrere 100 TByte skalieren können.

Beständige Leistungserbringung: Ein All-Flash-Array benötigt eine konstant hohe Leistung, sprich 100.000 IOPS und höher. Ziel des Arrays sollte es sein, jede Anfrage in weniger als 1 Millisekunde zu verarbeiten, damit 99,5 Prozent aller Anforderungen erfüllt werden.

Ein Flash-Array hat auf den SSDs keine Hotspots – ein LUN (Logical Unit Number) von 1 TByte performt genau gleich wie hundert LUNs derselben Grösse.

Unlimitierte Anzahl Kopien: Viele Unternehmen setzen seit Jahren Clones als Teil ihres Backups-Konzepts sein. Während bei den traditionellen Speichersubsystemen die Anzahl und die Qualität dieser Kopien limitiert war, kann ein All-Flash-Array Tausende oder sogar Zehntausende Kopien erstellen und dies, ohne zusätzlichen Speicherplatz zu verwenden.

Längerer Lebenszyklus dank Inline-Datenreduktion

Alle aktuellen Betriebsmodelle eines Speichersubsystems verlangen einen Hardware-Ersatz nach vier oder fünf Jahren. Speicherhersteller begründen dies häufig mit der höheren Ausfallwahrscheinlichkeit von rotierenden Disks. Ab dem vierten Betriebsjahr werden deshalb höhere Wartungskosten verrechnet. Vorhandene Kapazitäten und Softwarelizenzen müssen daher jedes Mal neu beschafft werden. Migrationsprojekte werden gestartet und Wartungsfenster während der Wochenenden eingeplant.

Ein All-Flash-Array mit Inline-Datenreduktion kann den Lifecycle verlängern. Dadurch, dass die SSDs nicht so stark beschrieben werden, ist es möglich, die Kapazitäten sieben oder zehn Jahre mit gleichbleibenden Wartungskosten zu betreiben.

Einige Hersteller haben ihr Wartungsmodell sogar so weit umgestellt, dass die Kapazitäten während eines laufenden Vertrags gar nicht mehr neu gekauft werden müssen und alle drei Jahre das Speichersubsystem kostenlos auf die neueste Technologie aktualisiert wird.

Die Speicherumgebung eines Unternehmens bleibt so immer aktuell – ohne kostspielige Investitionen und aufwendige Datenmigrationen. Besonders attraktiv ist dies für Kunden angesichts der Tatsache, dass sich Flash-Arrays in den nächsten Jahren viel stärker erneuern werden.

Wie sieht die Zukunft aus?

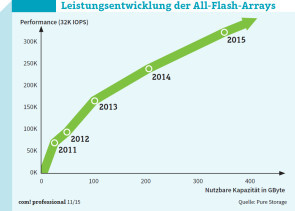

Die Kapazitäten der vorhandenen All-Flash-Arrays hat sich in den letzten vier Jahren verzwölffacht. In zwölf bis 24 Monaten dürfte 1 Petabyte nutzbare Kapazität auf drei Höheneinheiten in einem Standard-19-Zoll-Rack bereits Realität sein.

Ein Kunde, der heute ein Array kauft, mit der Absicht, dieses fünf Jahre zu betreiben, wird in weniger als zwölf Monaten ein Array auf dem Markt finden, das bei gleicher Kapazität nur noch halb so teuer ist.

Diese Entwicklung muss dem Kunden bei seiner Entscheidung bewusst sein. Er sollte eine Lösung wählen, die diese Innovationszyklen berücksichtigt. Ansonsten kann die heute erworbene Innovation nach fünf Jahren schnell zu einem Nachteil werden.

Der Flash-Speicher-Markt im Enterprise-Umfeld

Die Preise für professionelle Solid State Drives für den Einsatz im Enterprise-Umfeld sind jedoch noch immer um Welten höher als die für die mechanischen und rotierenden Pendants – ganz im Gegensatz zum Consumer-Markt, wo sich die Preise pro GByte Speicherplatz von Solid States Drives langsam aber sicher denen von herkömmlichen Festplatten annähern.

Der Grund liegt unter anderem darin, dass Solid State Drives für den Enterprise-Bereich erheblich höhere Anforderungen an die Zuverlässigkeit und Ausdauer im Vergleich zu Consumer-Modellen erfüllen müssen. So laufen SSDs in einem Rechenzentrum in der Regel täglich rund um die Uhr.

Und da kommen die Nachteile von SSDs zum Tragen: Neben der immanenten Fehleranfälligkeit, die sich durch Software ausgleichen lässt, ist das vor allem die Lebensdauer. So haben SSDs wie erwähnt nur eine begrenzte Lebensdauer und ermöglichen nur eine beschränkte Anzahl an Schreibzyklen – oft als Total Bytes Written (TBW) oder Drive Writes Per Day (DWPD) angegeben.

Der mittlerweile von vielen Herstellern genannte DWPD-Wert gibt an, wie oft sich die SSD während ihrer zu erwartenden Einsatzdauer von in der Regel fünf Jahren täglich komplett be- beziehungsweise überschreiben lässt.

Um die hohen Anforderungen für den Einsatz in Rechenzentren zu erfüllen, setzen die Hersteller von Solid State Drives bei ihren Enterprise-Modellen auf hochwertigere Komponenten, etwa bei der Qualität des Flash-Dies. Zudem kommen in den SSDs unter anderem Extras wie Kondensatoren zum Einsatz, die bei einem Stromausfall dafür sorgen, dass das Flash-Laufwerk seine Schreibvorgänge noch zu Ende führen kann.

Die Hersteller von Enterprise-SSDs setzen mittlerweile fast nur auf MLC-NAND-Speicher (Multi-Level Cells) anstelle des langlebigeren, aber deutlich teureren SLC-NAND-Speichers (Single-Level Cells). Dafür hat MLC-NAND-Speicher andere Vorteile: MLC speichert im Gegensatz zu SLC mehrere Bits pro Zelle – und ermöglicht eine höhere Kapazität auf der gleichen Chip-Fläche. Die Entwicklung geht jedoch noch weiter in diese Richtung, etwa mit in mehreren Lagen gestapelten Zellen wie beim 3D-V-NAND (Vertical NAND) von Samsung.

Neues gibt es von Intel und Micron: Die Speichertechnik 3D XPoint soll bis zu 1000-mal schneller und bis zu 1000-mal haltbarer sein als bisheriger Flash-Speicher. Die Datendichte soll bis zu 10-mal höher sein. Erste Speicher werden jedoch nicht vor Mitte nächsten Jahres erwartet.