Rechenzentrum

05.07.2022, 11:47 Uhr

Die Renaissance der Rechenzentren

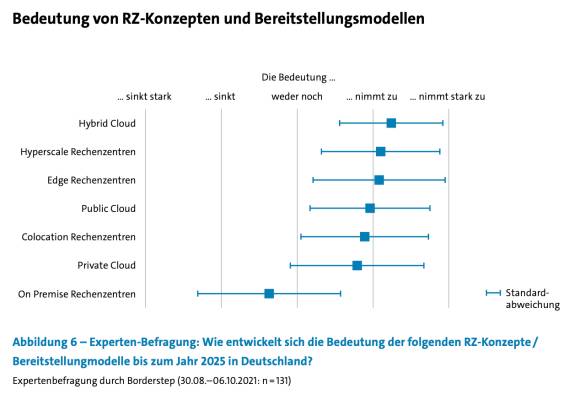

Befeuert von Trends wie Cloud und Edge-Computing erweist sich das Rechenzentrum als quicklebendig und wachstumsstark. Doch unterliegt diese Form der IT-Infrastruktur einem tiefgreifenden Wandel.

Ohne ein eigenes Rechenzentrum ist ein Unternehmen – so hiess es lange Zeit – nicht überlebensfähig. Doch solche landläufigen Annahmen sind ins Rutschen geraten. Nicht zuletzt durch die Hyperscaler von AWS bis Alibaba, Microsoft bis Google machen diverse Outsourcing-Alternativen dem guten alten eigenen Rechenzentrum Konkurrenz. Das eigene Rechenzentrum sei überholt und könne bei Leistungen und Kosten nicht mithalten, lautet die Parole des Tages. Doch stimmt das denn?

Die These vom baldigen Tod des Rechenzentrums in die Welt gesetzt haben unter anderem die Analysten von Gartner. Susan Moore postulierte im August 2019, dass „die Rechenzentren (fast) tot“ seien. Der Trend von den traditionellen Rechenzentren weg werde sich fortsetzen. Wenn in der Vergangenheit Geschäftsbereiche neue Anwendungen oder Services hätten haben wollen, hätten sie sich zuerst gefragt: „Wie können wir sie erstellen?“ Heute laute die Frage: „Wo können wir sie finden?“

Moore ging sogar so weit, vorherzusagen, dass bis 2025 80 Prozent der Unternehmen ihre klassischen Rechenzentren komplett schliessen würden (gegenüber gerade einmal 10 Prozent 2019). Unternehmen mit älteren Rechenzentren, so Moore, hätten aus Kostengründen kein Interesse mehr daran, sie zu modernisieren oder neue zu bauen. Sie würden sich stattdessen nach neuen Organisationsformen für ihre IT umsehen. Eine Folge: Der Anteil der IT-Kosten, der auf die eigenen Rechenzentren entfalle, sei in den letzten Jahren auf nur noch 17 Prozent gesunken.

Co-Location stark im Kommen

Auch wenn die Betreiber und Anhänger von Cloud-Computing dies gern behaupten, so hat das klassische Rechenzentrum keineswegs ausgedient. Bei der modernen Variante Co-Location dominieren Mischformen. Eine (teurere) Variante besteht dabei darin, Rechenzentrumsplatz für die eigenen Geräte anzumieten, ohne dass man dafür eine komplette eigene Struktur samt Gebäude und allen Service-Leistungen besitzen muss. Man kann aber auch nach Bedarf einzelne Server- und Speicherplätze sowie Dienstleistungen für seine Programme und Daten anmieten.

Aktuell überwiegt der Fall, dass ein Kunde Platz in Server-Racks oder -Räumen anmietet, während das Co-Location-Gebäude des Vermieters Energie, Internetanschluss, physische Sicherheit und Schutz gegen Umweltgefahren liefert. Bei den Kunden liegt in der Regel die Verantwortung für den Betrieb und die Verwaltung der eigenen Hardware-Geräte und die Software-Installationen, doch kann das auch an Dienstleister ausgelagert werden.

Laut einer Studie des Digitalverbands Bitkom, die von NTT unterstützt wurde, ist Co-Location im Kommen. Auf diese Rechenzentrumsvariante entfallen bereits etwa 40 Prozent der Kapazitäten in Deutschland. Das bedeutet, dass schon rund 10.000 Unternehmen auf solche Services setzen: Sie können oder wollen sich nicht mehr um den Betrieb und den Unterhalt einer Infrastruktur im eigenen Rechenzentrum kümmern. Laut Schätzungen soll der Co-Location-Anteil 2025 sogar auf 50 Prozent steigen, berichtet Bitkom. Weitere Details finden sich in der umfangreichen Bitkom-Publikation „Rechenzentren in Deutschland. Aktuelle Marktentwicklungen, Stand 2022“.

Besonders oft wird Co-Locaton, die gemeinsame Nutzung externer Rechenzentren, laut Gartner als Ersatz für traditionelle Data-Center eingesetzt. Gründe seien Vorteile wie höhere Verfügbarkeit, Zuverlässigkeit, gesetzeskonforme Baurichtlinien, Energieeffizienz, Gebäudemanagement und gute Erweiterungsbedingungen. On-Premise bleiben nach Gartner Prozesse, die besonders geschäftskritisch sind und grössere Kontrollmöglichkeiten erfordern, als es bei Cloud- und gehosteten Modellen der Fall sei.

Wer Co-Location nutzt, kommt in den Genuss einiger Vorteile des Cloud-Computings, ohne gleich die kompletten Verfūgungsrechte an einen Dritten abzutreten. Die gesamten Kapitalkosten für die IT (Capex) sollen sinken, man braucht prinzipiell auch keine eigenen Rechenzentrumsgebäude inklusive ihres Betriebs und ihrer Instandhaltung mehr. Allerdings behält man weiter die Kontrolle über die im eigenen Besitz befindlichen Gerätschaften samt eigener Software. Mischformen mit mehr oder weniger eigenem Besitztum gehören zu dieser Form der IT.

Edge-Computing verwandelt Rechenzentren

Der Rechenzentrumsbetreiber und Dienstleister Vertiv aus den USA, der in 130 Ländern präsent ist und etwa 20.000 Mitarbeiter beschäftigt, prognostiziert allerdings für die nächsten fūnf Jahre einen leichten Rückgang für Co-Location-Betriebe von derzeit 15 auf 14 Prozent. On-Premise-Installationen sollen sich in diesem Zeitraum von derzeit 45 auf 35 Prozent verringern – ein deutlich weniger starkes Schrumpfen, als IDC in einer Voraussage von 2019 angenommen hatte. Und auch die Public Cloud soll sich in diesem Zeitraum von 19 auf nur 25 Prozent steigern.

Ein wesentlicher Grund dafür ist Edge-Computing. Vertiv postuliert: „Umfangreiche, branchenweite Edge-Computing-Investitionen werden das Erscheinungsbild der Rechenzentrums-Branche in den nächsten vier Jahren verändern. Der Anteil der Edge-Komponente an der gesamten Datenverarbeitung wird in diesem Zeitraum um 29 Prozent steigen – nämlich von 21 Prozent Anteil an der gesamten Datenverarbeitung derzeit auf 27 Prozent im Jahr 2026.“

Die fortschreitende Verlagerung der Branche hin zu Edge-Computing gehört laut Vertiv zu den wesentlichen Ergebnissen einer aktuellen Umfrage unter Rechenzentrumsfachleuten weltweit. So plane ein Drittel (34 Prozent) der Unternehmen entweder eine umfangreiche Edge-Einführung oder sei bereits mittendrin. Ein Viertel habe neue, massgeschneiderte Edge-Standorte eingerichtet, 41 Prozent betrieben bereits bestehende Edge-Standorte.

Mit Edge wird heute ein Vordringen von Cloud-Elementen in die IT-Infrastruktur eines Unternehmens bezeichnet – man könnte auch von einer Art Mittelstück oder Konnektor sprechen: „Das Wort Edge bedeutet in diesem Zusammenhang buchstäblich eine geografische Verteilung. Edge-Computing ist eine Datenverarbeitung, die an oder in der Nähe der Datenquelle durchgeführt wird, anstatt sich auf die Cloud in einem von einem Dutzend Rechenzentren zu verlassen, die die gesamte Arbeit erledigen. Das bedeutet nicht, dass die Cloud verschwinden wird. Es bedeutet, dass die Cloud zu Ihnen kommt“, schreibt, das Technik-Portal „The Verge“ im Mai 2018. Eine ähnliche Sicht vertritt die Linux Foundation in dem Report „State of the Edge 2021“.

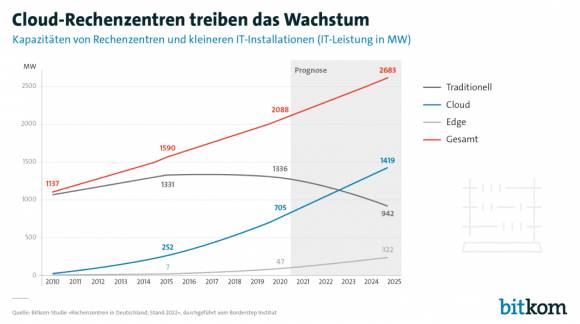

Vertiv prophezeit Edge-Computing in dem Bericht „Edge-Archetypen 2.0 – einsatzbereite Edge-Infrastrukturmodelle“ ein deutliches Wachstum. Stand heute gibt es in Deutschland laut Bitkom etwa 90 grosse Rechenzentren, die fast die Hälfte der gesamten Kapazitäten stellen. Daneben existieren etwa 3000 kleinere Rechenzentrumsbauten, die durch eine langsam steigende Nachfrage nach Edge-Kapazitäten mehr werden könnten, sowie etwa „47.000 kleinere IT-Installationen“.

Wenn man allerdings die Bitkom-Zahlen für On-Premise- und Edge-Installationen summiert, ändert sich insgesamt gar nicht so viel:

2022: 45 % On-Premise plus 21 % Edge = 66 %

2027: 35 % On-Premise plus 27 % Edge = 62 %

2027: 35 % On-Premise plus 27 % Edge = 62 %

„Edge-Computing ist ein Schlüsselelement“

Adrian O’Connell, Senior Research Director bei Gartner, wagt Prognosen zur Zukunft des Rechenzentrums.

com! professional: Welche Trends sehen Sie gegenwärtig bei den Rechenzentren als besonders wichtig an?

Adrian O’Connell: Das ähnelt in gewisser Weise den Trends, die wir seit einiger Zeit mit dem stetigen Wachstum der Public Cloud und den eingeschränkteren Aussichten für On-Premise beobachten. Nach Covid-19 haben wir eine weitere Beschleunigung in Richtung Public Cloud erlebt, da viele Unternehmen versucht haben, ihre Initiativen zur digitalen Transformation zu beschleunigen, um die Herausforderungen der Jahre 2020 und 2021 zu bewältigen, aber auch, um sich für künftiges Wachstum optimal zu positionieren.

com! professional: Welche Rolle kommt in dieser Entwicklung dem Edge-Computing zu?

O’Connell: Für Rechenzentrumsarchitekturen ist Edge-Computing ein Schlüsselelement, da die Bedeutung des Standorts sowie Bandbreiten-, Leistungs- und Datenhoheitsprobleme die Nachfrage nach lokalen Kapazitäten erhöhen. Aus einer breiteren Perspektive betrachtet werden jedoch zunehmend Technologien wie Künstliche Intelligenz, intensivere Analysen und Automatisierung eingesetzt, die diese Initiativen zur digitalen Transformation unterstützen können.

com! professional: Welche Technologien bestimmen aus Ihrer Sicht denn die Zukunft der Rechenzentren?

O’Connell: Das sind mehrheitlich die schon bekannten Technologien. Bei den Technologien, die den Ausbau von Rechenzentren vorantreiben, sind es die üblichen Systemtypen von Servern, Speicher und Netzwerken, aber die Art und Weise, wie die Käufer diese nutzen und priorisieren, wird unterschiedlich sein. Hyperscaler-Käufer – also Anbieter wie AWS, Microsoft Azure oder Google Cloud – werden sich auf Server und die dazugehörige Netzwerkausrüstung konzentrieren, während die Unternehmen eher eine breitere Mischung von Systemen einsetzen werden. Wenn Sie sich unsere Prognosen für die gesamten Rechenzentrumssegmente ansehen, ergibt sich das folgende durchschnittliche jährliche Wachstum für die drei Schlüsselsegmente für 2020 bis 2025: Server 5,4 Prozent, Netzwerkausrüstung 5,6 Prozent und Storage 1,3 Prozent.

com! professional: Das klingt aber doch nach eher bescheidenen Wachstumszahlen, oder nicht?

O‘Connell: Eigentlich nicht, denn man muss die bereits bestehende Ausgangsbasis berücksichtigen. Dann erhält man sowohl einen Eindruck von der Dynamik, die jedem Markt zugrunde liegt, als auch einen Überblick darüber, wie sich die Käufer dieser Geräte verändern. Wie ich schon sagte, findet sich bei den Käufern aus dem Hyperscaler-Segment eine andere Mischung von Infrastrukturen, und es sind diese Käufer, die das Gesamtwachstum des Marktes vorantreiben.

com! professional: Oft wird behauptet, dass Public Clouds bereits das Ende privater Rechenzentrumsinfrastrukturen in den Unternehmen eingeläutet haben. Wie sehen Sie das?

O’Connell: Trotz des eindeutigen Trends hin zu einer stärkeren Nutzung von Public Clouds sehen wir keinen sprunghaften Rückgang bei den traditionellen Umgebungen und Käufern.

Um den Server-Markt zur Veranschaulichung heranzuziehen: Während wir für das Gesamtmarktvolumen eine jährliche Wachstumsrate (CAGR) von etwa 5 Prozent für die Jahre 2020 bis 2025 erwarten, rechnen wir für das Segment der traditionellen Käufer mit einem Rückgang von etwa 1 Prozent. Es handelt sich also definitiv zwar nicht um einen Wachstumsbereich, aber immer noch um einen bedeutenden Marktbereich für die OEMs, die sich darauf konzentrieren.

com! professional: Und wie beurteilen Sie die Aussichten auf dem Co-Location-Markt?

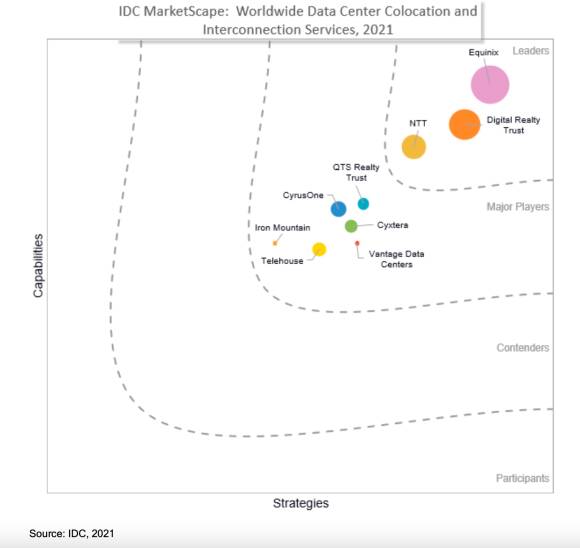

O’Connell: Was die Co-Location-Anbieter betrifft, so profitieren diese Unternehmen von zwei Trends: Zum einen geben Unternehmensanwender ihre eigenen Einrichtungen auf und greifen zunehmend auf Drittanbieter zurück, zum anderen wachsen die Hyperscaler, die entweder ihre Präsenz in neuen Regionen ausbauen oder ihre Kapazitäten in bestehenden Regionen stärker lokalisieren wollen.

Die Aussichten für Co-Location-Anbieter sind also recht positiv. Hier gibt es viele bedeutende Dienstleister. Neben Equinix sind es weitere multinationale Anbieter wie Digital Realty, Iron Mountain, Interxion oder Verizon, aber auch viele lokal ausgerichtete Anbieter, die ähnliche Leistungen auf Länderebene bereitstellen.

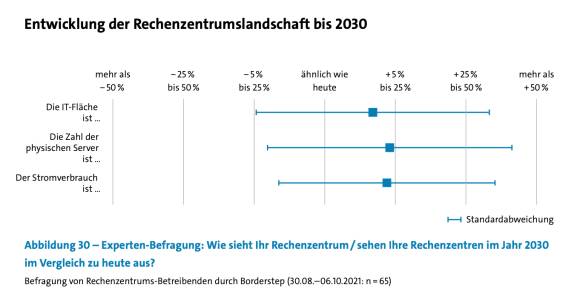

Rechenzentrumslandschaft wird diverser

Die umwälzende, von Gartner 2019 angekündigte Rechenzentrumsrevolution ist bislang ausgeblieben. Bereits 2020 rūckte das Analystenhaus denn auch wieder etwas ab von seiner steilen These, wie die Studie „Your Data Center May Not Be Dead, but It’s Morphing“ vom September 2020 zeigt, in der der Begriff „Hybrid Digital Infrastructure Management (HDIM)“ geprägt wurde. Auch die Analysten der Enterprise Strategy Group (ESG) sprechen in einer Studie vom Mai 2020 von „Hybrid Cloud Trends“.

Die Entwicklung hin zu einer neuen Diversität wird auch deutlich, wenn man sich die wesentlichen Merkmale einer Cloud-Installation näher ansieht. Wenn Unternehmen Teile oder die komplette Ausrüstung für ihre Daten und Workloads in ein Cloud-Rechenzentrum auslagern, dann befinden sich diese in physischen Infrastrukturen, wie man sie in den klassischen Rechenzentren von Unternehmen vorfindet – allerdings nicht mehr exklusiv, sondern mit denen von anderen Unternehmenskunden.

Der Begriff Cloud bezeichnet den Umstand, dass solche zentralen Rechenzentren irgendwo anders stehen und über zugewiesene, spezielle oder allgemein zugängliche Internetleitungen mit dem Unternehmenssitz verbunden sind. Sie können sich in der gleichen Region, innerhalb eines Landes oder irgendwo auf dem Globus befinden – je nachdem, wie es die Vorgaben des jeweiligen Staates erlauben. In dieser Standortlogik kommt den Leitungen zwischen Kunden und Rechenzentrumsbetreibern eine neue Bedeutung zu: Ihr Sicherheitsstatus muss gewährleistet sein, sie können sich aber in der Praxis auch als Einfallstor für Attacken von Cyberkriminellen erweisen.

Zu den Vorteilen für den Kunden zählt, dass er sich nicht mehr selbst um Bau, Betrieb, Energieversorgung, Fachleute und physische Sicherheit seines Rechenzentrums zu kümmern braucht. Dafür trägt der Cloud-Provider die Verantwortung, ebenso wie für alle Komponenten auf Applikations- und Datenseite – Komfort gegen bare Mūnze, je nach Ausgestaltung der individuellen Verträge.

Die Cloud-Betreiber wiederum stellen für die gemeinsame Nutzung ihrer Anlagen eine virtuelle Aufteilung ihrer Server- und Storage-Ressourcen zur Verfügung – mittels virtueller Maschinen (VMs) oder gegen Aufpreis durch einen dedizierten exklusiven Ressourcenzugang. Diese Möglichkeiten unterscheiden sich je nach Provider.

Zu den prinzipiellen Vorteilen einer Public Cloud gehört die gemeinsame Nutzung von Ressourcen. Unternehmen müssen nicht mehr alles an Gebäuden und Installationen aus eigener Tasche bezahlen, sondern nur einen individuellen Anteil. Bei Erweiterungen oder Reduzierungen greifen Vertragsklauseln, die Kunden können variabler (und billiger) reagieren, die eigenen Kapitalausgaben gestalten sich kostengünstiger und Ausstattung und Anforderungen an ein eigenes IT-Team fallen geringer aus.

Die Kehrseite der Medaille: Die Kunden geben die Durchfūhrung und Planung von IT-Prozessen weitgehend aus der Hand – ein Prozess, der sich auch bei anderen Teilbereichen einer modernen Unternehmensführung findet: Ausgliederung von Prozessen wie Schreibbüros, Lager, Transportmittel oder Abwicklung von Steuerunterlagen. Insofern folgen zentrale Cloud-Rechenzentren einer allgemeinen Entwicklung der Auslagerung von Services und Technologien.

Problematisch bleibt die mangelnde Übersicht der Kunden über „ihre“ Bestandteile der Infrastruktur im Rechenzentrum des Dienstleisters. Werden sie tatsächlich, wie in den Prospekten und vertragsmässig versprochen, fortlaufend kontrolliert und erneuert? Wie konstant ist die Preisgestaltung? Was passiert genau, wenn man wieder aussteigen, zu einer eigenen IT zurückkehren oder zu einem anderen Provider wechseln möchte? Nicht zu vergessen: das abschreckende Beispiel der verheerenden Brandkatastrophe bei OVHcloud in Frankreich.

Fazit & Ausblick

Ganz ohne Schattenseiten ist die Verbindung Cloud und Rechenzentren nicht. Das Uptime Institute geisselte Anfang März 2022 in dem Paper „Flexibility drives cloud lock-in risk“ das „hochflexible Modell der Cloud“ als „Triebfeder für Lock-in“. Und problematisiert den Faktor Preis: „Die Cloud war wegen ihres Preismodells revolutionär, nicht unbedingt wegen der Kerntechnologie. (…) Das Cloud-Modell setzt den Käufer unerwarteten Preissteigerungen aus (...). Bislang sind die Cloud-Preise insgesamt tendenziell gesunken – aber es gibt keine Garantie dafür, dass dies immer der Fall sein wird.“

Und noch etwas ist bei der Renaissance der Rechenzentren mitzubedenken: ihr Energiehunger. Die fortschreitende Digitalisierung aller Lebens- und Wirtschaftsbereiche bringt einen wachsenden Energieverbrauch durch immer mehr Rechenzentren mit sich, aber immerhin nutzen diese die eingesetzte Energie effizienter. Doch das kompensiert den Mehrverbrauch nicht ganz. Das einzelne Rechenzentrum mag effizienter sein, dafür gibt es aber immer mehr und immer grössere. Der Anbieter von weltweiten Rechenzentrums-Services NTT konstatiert in einem Papier vom Februar 2022 deshalb: „Rechenzentren benötigen circa 3 Prozent des in Deutschland verbrauchten Stroms. Dabei ist sowohl die Rechenzentrumsinfrastruktur als auch die IT-Hardware in den vergangenen Jahren immer effizienter geworden, sodass sich die Zahl der installierten Workloads pro Kilowattstunde Strom seit 2010 verfünffacht hat. Insgesamt stieg der Energiebedarf der Rechenzentren zwischen 2010 und 2020 von 10,5 auf 16 Milliarden kWh pro Jahr. Die schnell wachsende Nachfrage nach Rechenzentrumsdiensten wird den Energiebedarf der Branche in Zukunft weiter erhöhen.“